Published : 27 Mar 2024 10:58 AM

Last Updated : 27 Mar 2024 10:58 AM

தேர்தல் வியூகத்தில் ஏஐ தொழில்நுட்பம் ஆதிக்கம் - அச்சுறுத்த காத்திருக்கும் ‘டீப் ஃபேக்’

2024-ம் ஆண்டு உலகத் தேர்தல் திருவிழா களமாக மாறியுள்ளது. இந்தியா தொடங்கி அமெரிக்கா உள்ளிட்ட உலகின் பல்வேறு நாடுகளில் தேர்தல் ஜூரம் பற்றிக் கொண்டுள்ளது. இன்றைய தேதியில் மனித குலத்துக்கு சவாலாக உள்ள செயற்கை நுண்ணறிவு (ஏஐ) தொழில்நுட்பம் பரவலாகப் பயன்பாட்டுக்கு வந்துவிட்டது. அண்டைநாடான பாகிஸ்தானில் கூட இம்ரான்கான் ஏஐ தொழில்நுட்பத்தைப் பயன்படுத்தி தேர்தல் பிரச்சாரத்தில் ஈடுபட்டார்.

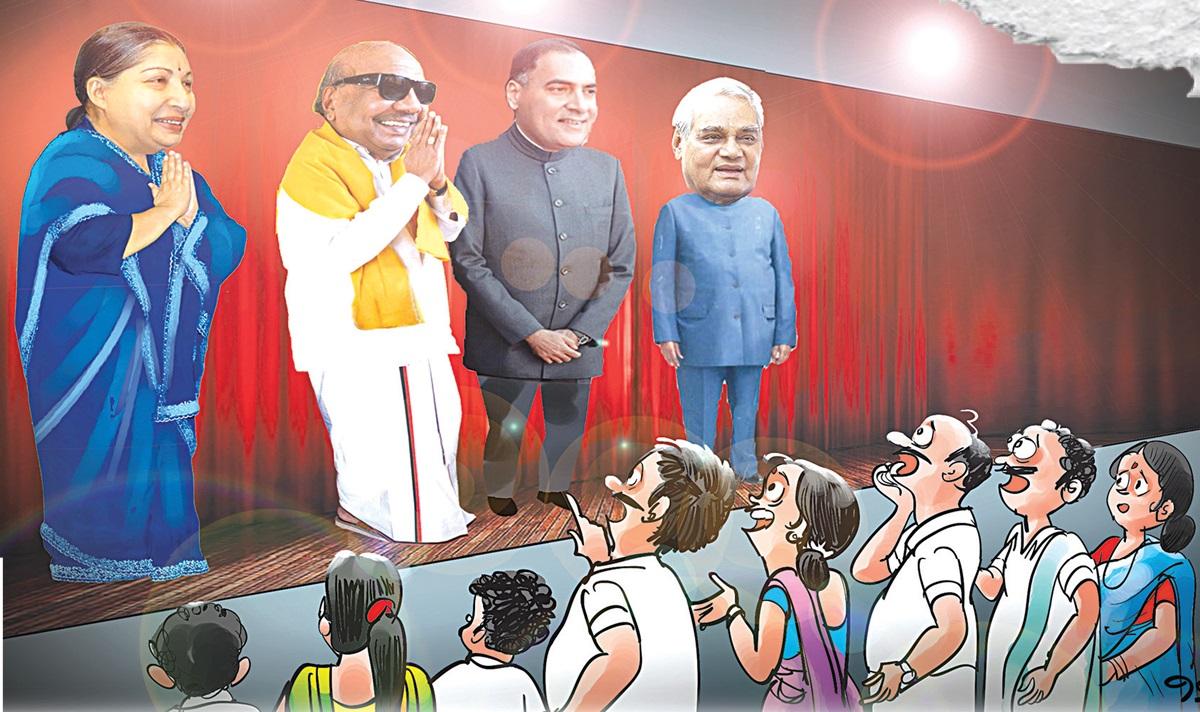

உயிருடன் இருப்பவர்கள், உயிருடன் இல்லாதவர்களுடன் நிஜமாகப் பேசுவது போன்ற வீடியோக்களை உருவாக்குவது ஏஐ தொழில்நுட்பத்தில் சாத்தியமாகி உள்ளது. தமிழகத்தில் மறைந்த முதல்வர்கள் கருணாநிதி, ஜெயலலிதா ஆகியோர் மறுஜென்மம் எடுத்து பேசுவது போலவும், கண் முன் உரையாடுவது போன்ற காட்சிகளும், குரல் பதிவுகளும் ஏஐ தொழில்நுட்பத்தில் வெளிவந்து வெகுஜன மக்கள் மூக்கின் மேல் விரல் வைக்கும் ஆச்சரியத்தை ஏற்படுத்தி உள்ளது. மக்களவைத் தேர்தலிலும், ஏஐ தொழில்நுட்பத்தை பயன்படுத்தி வேட்பாளர்கள் பிரச்சாரத்தில் ஈடுபடுவார்கள் என எதிர்பார்க்கப்படுகிறது.

இதுகுறித்து, கோவை அரசு கலை அறிவியல் கல்லூரியின் அரசியல் அறிவியல் துறை தலைவர் பேராசிரியர் கனகராஜ் கூறியதாவது: உலகெங்கும் புதிய தொழில்நுட்பம் அறிமுகப்படுத்தும் போதெல்லாம் அச்சப்படுவதைப் பார்க்க முடிகிறது. கம்ப்யூட்டர் வரும்போது மனிதர்கள் தங்கள் வேலை பறிபோய்விடுமோ என அச்சத்தில் ஆழ்ந்தனர். இப்போது அப்படி ஒரு அச்சத்துக்கு ஏஐ தொழில்நுட்பம் வித்திட்டுள்ளது.

ஏஐ தொழில்நுட்பம் இரட்டை முனை கத்தி போன்றது. அதாவது ஒரு மருத்துவர் கத்தியை கையாள்வது, சமூக விரோத சக்திகள் கத்தியை கையாள்வது ஆகியவற்றில் இருக்கும் வித்தியாசம் தான் இந்த ஏஐ தொழில்நுட்பத்தைப் பயன்படுத்துவதிலும் உள்ளது. ஒரு லட்சம் ஹேக்கர்கள் மூலம் தைவான் நாட்டை நிலை குலைய வைத்தது சீனாவின் தந்திரத்தில் ஒன்று. இந்தியாவுக்குப் பின்னர், வரும் நவம்பரில் அமெரிக்காவில் தேர்தல் வரப்போகிறது. வல்லரசு நாடுகளான ரஷ்யா, சீனா, ஈரான் ஆகிய நாடுகள் ஏஐ தொழில்நுட்பம் மூலம் அமெரிக்கத் தேர்தல்களில் ஊடுருவ வாய்ப்புள்ளது என அரசியல் நோக்கர்கள் அச்சப்படுகின்றனர்.

முதலில் டீப் ஃபேக் தொழில்நுட்பத்தில் போலி தகவல்களை பரப்புதல் தேர்தல் காலத்தில் எதிர்வினையாற்றும். ஏஐ தொழில்நுட்பத்தில் கோடிக்கணக்கில் ஆடியோ, வீடியோ ஃபைல்களை ஒரே நேரத்தில் பலரது செல்போனுக்கும் அனுப்பிவிட முடியும். சமூக நலனுக்கு எதிரானவர்கள் சிலர், டீப் ஃபேக் தொழில்நுட்பத்தில் வீடியோ, ஆடியோ வெளியிடுவது நல்லதல்ல. இரண்டாவதாக ஜெனரேட்டிவ் ஏஐ தொழில்நுட்பம் மூலம் சாமானிய மக்கள் கூட வீடியோக்களை உருவாக்கிவிட முடியும். மூன்றாவதாக வதந்தி பரப்பும் தொழில்நுட்பமும் தேர்தல் காலங்களில் உற்று கவனிக்க வேண்டியது அவசியம்.

வீடியோ அல்லது ஆடியோக்களில் வரும் தகவலை வாக்காளர்களோ அல்லது பொதுமக்களோ உடனே நம்பி விடக் கூடாது. மெய்ப்பொருள் காண்பது அறிவு என்ற கோணத்தில் அலசி ஆராய்ந்து உண்மை அறிய வேண்டும் என்றார். இந்தியாவிலேயே முதல்முறையாக தொலைக்காட்சியில் ஏஐ தொழில்நுட்பத்தில் செய்தி வாசிப்பாளரை அறிமுகப்படுத்திய பார்சனேட் நிறுவனத்தின், நிறுவன உறுப்பினரான கோவையைச் சேர்ந்த ஜெய் அரவிந்த் கூறியதாவது: மக்களவைத் தேர்தல் பிரச்சாரத்தில் தீவிரமாக இருப்பவர்கள் சில இடங்களுக்கு நேரில் செல்ல முடியாது.

இக்கட்டான சூழலில் வேட்பாளர் அல்லது கட்சியின் தலைவரை அவர்களின் ஒப்புதல் பெற்று சட்ட ரீதியாக டிஜிட்டல் அவதார் மூலம் ஆடியோ, வீடியோ குளோனிங் மூலம் அவர்களின் தேர்தல் பிரச்சாரம் குறித்த வீடியோவை ஒவ்வொரு வாக்காளருக்கும் கொண்டு சென்றடைய முடியும். ஒவ்வொரு வாக்காளரின் செல்போனுக்கும் வாட்ஸ் அப் மூலம் வீடியோ, ஆடியோவை கொண்டு சென்று டிஜிட்டல் பிரச்சாரம் செய்ய முடியும்.

அதேவேளையில், சட்டத்துக்குப் புறம்பாக டீப் ஃபேக் தொழில்நுட்பத்தில் ஆடியோ, வீடியோக்கள் மூலம் வெறுப்பு பிரச்சாரம் செய்யப்படும் சூழல் உள்ளது. இதுபோன்ற டீப் ஃபேக் தொழில்நுட்ப வீடியோக்கள் தேர்தல்களில் இறுதிக்கட்டத்தில் வேட்பாளரின் வெற்றி, தோல்வியை மாற்றியமைக்கும் அபாய போக்கு உள்ளது.

டீப் ஃபேக் வீடியோ, ஆடியோக்களை பொருத்தவரை வாய்ஸ் ஜெனரேட்டர் மூலம் தலைவர் ஒருவரின் உண்மையான பேச்சை, தவறான பொருள் கொண்ட வெறுப்பு அர்த்தத்தை உருவாக்கி வைரல் ஆக்க முடியும். இதுபோன்ற டீப் ஃபேக் வீடியோக்கள் வாக்காளர்களை எளிதில் சென்று எது உண்மை என தெரியாமல் குழப்பத்தை ஏற்படுத்தி விடும். ஏஐ தொழில்நுட்பத்தில் நல்ல அம்சங்கள் நிறைய உள்ளன. அதனை ஆக்கப்பூர்வமாகப் பயன்படுத்திட வேண்டும், என்றார்.

FOLLOW US

தவறவிடாதீர்!

Sign up to receive our newsletter in your inbox every day!

WRITE A COMMENT